30多年前,钱学森先生提议将 “Virtual Reality”翻译为“灵境” ,并预言VR技术将成为促进人机结合以及人类社会进化的一个技术路线。世纪之交上映的 《黑客帝国》三部曲 ,向观众展示了Matrix虚拟空间中真假难辨的虚幻与现实。

2023年6月的WWDC(苹果全球开发者大会)上,研发了7年之久的 苹果Vision Pro面世。

Vision Pro是一款AR(Augmented Reality,增强现实)与VR(Virtual Reality,虚拟现实)融合的混合现实设备。从人机交互、硬件规格到操作系统,它的多项指标都为近年来处于探索阶段的XR行业带来了新的产品标准。因此,Vision Pro的面世也被行业评价为 “XR(XR,extended reality,扩展现实)的iPhone时刻”。

从科幻电影中真假难辨的虚拟空间,到苹果的突破性XR设备Vision Pro,在本篇报告中,我们将层层深入,聚焦XR行业,探讨如下问题:

30多年前,钱学森在一封写给时任“863计划”智能计算机专家组组长汪成为的信中,提议将“Virtual Reality”翻译为“灵境”,并在后续的信件中预言,VR技术将成为促进人机结合以及人类社会进化的一个技术路线。

世纪之交上映的《黑客帝国》三部曲,向观众展示了Matrix虚拟空间中虚幻与现实的交织。在科幻电影中,人们通过脑后“插管”等脑机接口技术,进入完全拟真的虚拟环境,与钱老对未来“人机融合”的“灵境”畅想不谋而合。

从科幻回到现实,2012年,创业公司Oculus首次在Kickstarter完成众筹,将VR设备带入了大众视野。Oculus后被Meta的前身Facebook收购。2016年,Oculus Rift发售,头戴显示器搭配上体感手柄的设计,成为了2016年VR元年前后业内主流的设备形态。HTC、索尼,以及国内的Pico纷纷入局推出各自的产品。

讨论虚拟现实,我们绕不开AR、VR、MR、XR这些概念,它们究竟指什么,区别在哪?

AR(Augmented Reality)通常被直译为增强现实。与虚拟现实VR不同,AR是将虚拟内容与现实物理世界叠加的技术。Google在2012年发布了Google Glass的原型机,是消费级AR设备较为早期的商业化探索。

MR(Mixed Reality)被译为混合现实,最早由科学家Paul Milgram 和 Fumio Kishino研究引入。2015年,微软发布HoloLens,让MR的概念进一步具象化,强调虚拟世界与现实世界的混合以及可交互。

MR与AR和VR似乎听起来都有类似之处,下图能够比较直观的体现三者的区别。

2017年,高通提出了XR(extended reality)扩展现实的概念,涵盖了VR、AR、MR的范 围,成为了虚拟现实交互类技术的统称。此后,高通还推出了XR的专用平台和基础硬件平台。

苹果Vision Pro的面世被行业评价为 “XR的iPhone时刻”。 虽然目前Vision Pro尚未在市场上正式面向消费者发售,但无论是相关的媒体测评还是官方披露的技术参数,都为整个行业“打了个样”,展现出了过硬的技术和产品水平,也吊足了人们的胃口。

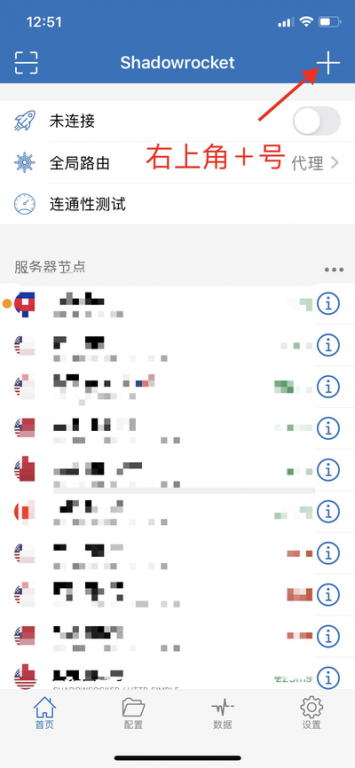

在外观上,Vision Pro的设计酷似潜水镜。边框在面部周围微微弯曲,更加贴合脸型,提升了佩戴的舒适度。此外,Vision Pro以 VST(video see through)的方式实现XR功能。用户并非直接透过“眼镜片”观察外界,而是先由摄像头采集外部环境画面,再通过低延时把画面显示在眼前的屏幕上。

在系统上,Vision Pro采用的visionOS操作系统被苹果称为 “第一个为空间计算而设计的操作系统” 。visionOS与iPhone的iOS操作系统看上去有些相似。与iPhone不同的是,它的系统界面以立体空间感的形式呈现,可以实现眼睛、双手、语音交互的空间操作。

在硬件上,Vision Pro更是被业内称为 “不计成本,极限堆料”。 Vision Pro拥有12个摄像头、一个激光雷达传感器(LiDAR),再加一个M2芯片和一个R1芯片作为双处理器。其中M2负责图形计算,R1负责对周边环境和用户手势的感知协助。设备采用Micro OLED显示屏,拥有双目2300百万像素,这也是业内最高规格的显示水平。

通过软硬件的创新,Vision Pro提升了用户的体验,无论是在办公室还是家里,用户眼前的显示面板和数字内容都能与所处环境相匹配。

具体来说,Vision Pro 从空间视听、五感交互、空间OS及内容生态三个方面 重构了以往的XR体验。

首先,在空间视听方面 ,Vision Pro的屏幕像素密度达到3386PPI,估算空间分辨率(Pixel per degree)约为35左右,即视场角中平均每1°夹角内填充的像素点的数量为35,这相当于每只眼睛分到的像素比4K电视还多。基于苹果Airpods耳机积累的空间音频技术,用户可以通过Vision Pro辨别声音从哪个位置传来,获得更加精准的空间视听体验。

其次,在交互方式上, Vision Pro采用了“眼动焦点交互”和“手势交互”两种人机交互设计,无需手柄等其他外接设备。这种基于人类本能设计的交互方式被称为五感交互,也叫自然交互。

最后,在空间OS和内容生态方面, 苹果一贯擅长将软硬件开发相结合,用软件系统的创新帮助打造更好的产品体验。这一次,苹果推出了空间操作系统visionOS。未来,或许会有更多应用接入visionOS系统,成为苹果产品体验的重要组成部分。

从Vision Pro公布的信息和目前媒体评测的反馈看,无论是Micro OLED带来的视觉体验,还是软硬件有机整合带来的良好交互和应用体验,都将用户视角下的XR体验带到了一个新的高度。并且,Vision Pro实现了VR与AR的无缝切换,相比于近年来的VR头显以及AR眼镜,实现了突破性的创新。

如果我们跳出当前现有的技术水平,满足用户预期的理想XR体验应该是怎么样的呢?

VR和AR的目标体验是有差异的。前者追求虚拟世界对真实世界的 完全替代美国id苹果账号有什么好玩的游戏, 后者追求虚拟世界与真实世界的 无缝融合。

单从科学幻想的效果来看, 未来的VR 也许像电影 《头号玩家》, 让用户沉浸到一个全新的世界,完全用虚拟世界替代现实世界。这需要以视觉、听觉为主的完全拟真的感官体验。而 未来的AR 也许像电影 《钢铁侠》 ,在现实世界中和虚拟面板进行交互,侧重于虚拟跟现实之间的无缝融合。

接下来,我们基于用户体验,将评价XR所需的技术指标进行拆解:第一是视觉空间维度的指标,即单帧画面质量;第二是视觉时间维度的指标,即动态响应速度;第三是交互与佩戴的体验 。

目前,智能手机屏幕的技术发展已十分成熟,显示效果接近于人眼视觉的极限。但VR设备与手机不同,屏幕距人眼仅在3-5厘米之内,是非常近场的显示。因此,评价VR的单帧画面质量时,我们通常采用的指标是空间分辨率(Pixel Per Degree,PPD)

空间分辨率指视场角中平均每1°夹角内填充的像素数量,由显示屏分辨率和光学系统共同决定。理想情况下,每1°夹角的像素数越高越好。

人眼正常视力的分辨能力极限在50PPD-60PPD,PPD小于50,就能感受到视觉上的网格感,也就是所谓的 纱窗效应。 目前主流的VR产品PPD大约在19-25,比如PICO 4的PPD是20.6,距离理想值还有较大差距。

苹果Vision Pro则预估在35左右,虽然已经远超其他厂家的产品,但它的 空间分辨率还需要提高75%以上才能满足拟真需求。 目前为止,还没有消费级产品的空间分辨率达到40以上,而达到60以上才能对应普通屏幕单眼8K、双眼16K的分辨率。因此,显示芯片技术还有很大提升空间。

左上、右上、左下、右下依次展示了空间分辨率(PPD)分别为10、20、30、40的显示效果;图片来源:ANSYS-HFSS

相信游戏爱好者一定不会对“渲染质量”感到陌生,它直接影响到游戏画面带来的沉浸感。对于主打沉浸式体验的XR来说,渲染质量同样重要。

渲染的四要素包含渲染对象的 材质贴图、几何体模型、光照、采样精度等 。这些参数越高,渲染质量越高,用户能看到的虚拟环境就越真实,沉浸度就越高。

虚拟物体以及环境的渲染,依赖计算机图形学中的 实时渲染管线(Real-time Rendering Pipeline)。 目前业内最先进的实时渲染技术是 混合光线追踪渲染管线。

与下图Meta元宇宙公布的渲染效果相比,2020年出品的游戏《Cyberpunk 2077》中,已经用上了业内最先进的混合光线追踪渲染管线。

从用户的视角来看,画面渲染质量如果不够好,会使虚拟环境的体验与现实差距过大,带给用户巨大的割裂感。

既然我们已经能看到十分精美的电影动画,为什么渲染质量还会成为XR的技术难题?

电影特效采用的是离线渲染方式,每一帧都提前花费大量时间渲染完成,再呈现到荧幕上。一部电影甚至需要数月的渲染时间,花费几亿资金。而XR却需要实时渲染,渲染后每个画面都会直接推流到屏幕上,对图形GPU的算力要求极高,需要极高性能的显卡。但高规格的显卡不仅数量较少,移动端的设备也无法支持,因此短期内, 渲染质量仍然受限于算力。

视觉的时间维度即动态响应速度。帧率是否够高,延时是否够短,直接关系到设备显示出的画面是否流畅丝滑,用户带上设备会不会“头晕眼花”。

帧率代表画面每秒重绘的次数,以Hz为单位。帧率越高,意味着显示内容动态越流畅清晰。目前主流VR头显的帧率在90Hz左右。而手机与显示器的帧率已经向120Hz以上发展。

XR的 “动作画面响应延迟”也就是MTP(Motion To Photons), 是指画面数据在传输、渲染等过程中的时间差和输入指令处理的时间差造成的延迟。

过高的延迟容易造成用户的 “3D眩晕症”。 如果用户眼动、头动甚至身体移动后,画面在100毫秒之后才发生变化,用户就会明显感到仿佛醉酒的眩晕状态。理想状态下,延迟短于20毫秒才不会引起人体的敏感。

图片展示了,在XR设备中,由于运算造成的延迟。图片来源:ResearchGate

目前主流的XR产品仍旧依靠手柄这类外接设备作为交互方式,在操作便捷度和直觉匹配上仍有较大提升空间。比如,当用户戴上VR或者AR眼镜,看到眼前的物体,会本能地伸出手去抓。但受限于多数设备的技术水平,用户经常会感觉够不到眼前的东西,或者手直接从影像穿过去了。

自然式交互是指用户以自然、基于直觉的方式与设备进行交互。最符合自然交互的方式是 手势结合眼动,以及语音交互 ,因为不需要额外配置控制器。Vision Pro走的就是自然式交互的路线。

触觉传感器也是一种自然交互的解决方案。但目前触觉传感设备相对昂贵,且不够稳定。所以,苹果Vision Pro在研发过程中放弃了触觉传感器的方案,选择了手势、眼动和语音结合的自然式交互。下面的图片是visionOS支持的一些操作手势。比如,通过放开和捏起手指,就能实现图像的放大缩小。

当前VR类设备的重量平均在500g左右,尽管产品设计在人体工学上投入大量精力,佩戴时间过长仍然会造成不适。与之相对,AR眼镜的设备重量已经能降低到200g以内。

值得注意的是,轻量化应当是在前述几项技术指标完善之后,进一步追求的目标,如果以现有的技术水平一味追求轻量化,用户的综合体验就无法得到保证了。

目前来看,XR行业面临的巨大挑战在于,用户期待更好的产品体验,但当下的技术暂时还满足不了用户的高期待。 和台式设备不同,XR设备只能借助移动端有限的算力和显示设备,并且XR设备功耗又偏高。

站在科技创业投资的角度,峰瑞一直关注关键技术点的突破,及其带来的爆发性商业机会。XR行业在2016年经历过一波热潮后,逐步沉淀下一些有商业化价值的B端需求,例如教育、工业巡检。而在C端,更好的产品体验背后,离不开关键技术迭代。

拆解了相关的技术指标,我们认为技术研发的关键挑战在于 提升XR的视觉体验。 这背后不仅涉及到 硬件端的显示模组与光学系统方案 ,也依赖 软件层面CG实时渲染技术 的进一步发展。此外,如何 改善画面运动延迟、提升沉浸感 也是目前XR设备的一大痛点。

人们在XR设备里看到的屏幕主要是由显示模组构成的。目前显示模组主要有 Fast-LCD、Micro OLED和Micro LED 这三种技术方案。

Micro OLED 具备高像素密度、高对比度的特性。但OLED是一种有机材料,容易老化,并且亮度比LED低不少。

相比于Fast-LCD和Micro OLED, Micro LED 或许是下一代显示模组更理想的方案。根据智东西报道,苹果已投入大量资金开发Micro LED。苹果于2014年5月收购LuxVue,该公司主营Micro LED 业务,拥有多项可用于苹果设备的Micro LED专利。

Micro LED兼具了LCD和OLED的优势,同样具有拥有高像素密度,高对比度,高分辨率等多重特性。Micro LED的亮度理论上可以达到10万尼特以上,高于Micro OLED两个数量级。并且,由于Micro LED在生产过程中不易受到污染,因此良品率更高,寿命也更长。

目前,全彩色Micro LED还处于研究阶段,没有实现大规模量产。如果要制备全彩色Micro LED,主要有三色集成和量子点转色两种路径,两种方案都处于技术早期,存在不同程度的挑战。

三色集成方案对微观制造工艺的要求非常高,需要所有单色器件具备较好的一致性。三色集成方案中,红光器件在尺寸缩小到微米级别甚至更小时,发光效率远低于绿光和蓝光器件。量子点转色方案则可以规避三色集成方案中的工艺难点,直接使用相对较成熟的蓝光器件作为光源,使用量子点材料转色得到红光与绿光。

然而, 不吃工艺的苦,就要吃材料的苦。 目前的量子点材料容易老化,使用寿命较短。另外,量子点器件的变色层有时会漏光把苹果id改成美国的账号,产生相互串扰。

由于工艺相对简单,量子点转色是目前大部分创业团队的主流选择。但从投资角度来看 ,两种技术路线仍处于竞争中,还需等待一个相对更成熟的关键点。 不管哪一种路线最终胜出,都将推动Micro LED技术的产业化。我们将持续关注Micro LED相关的工艺、材料以及设备等方向的技术创新。

XR设备屏幕离人眼很近,人眼很难聚焦。所以,人们需要设计一套独特的光学系统,让光线在狭小的空间内多次传导,使人眼能够清晰聚焦显示面板上的内容。

目前,在VR领域,Pancake超短焦折叠光路方案已经成为新款头戴设备的主流选择。当前苹果Vision Pro、字节旗下的Pico4均采用此方案。据财联社报道,Pancake解决了VR模组过于厚重的痛点,可将机身厚度降低约50%。

而在AR领域,衍射光波导方案将成为AR主流的光学设计,整体结构轻薄,视场角FOV与分辨率高。但目前衍射光波导技术的整体成熟度还不够高,存在色散(由于光线的折射和散射现象导致的色彩偏移现象)和光损控制(光在传播过程中的亮度损失)的问题。

往前沿的方向看,超透镜(Metalens)与微透镜阵列是行业预期的下一代XR光学技术路线。超透镜是使用超表面(一系列亚波长厚度的平面二维结构材料)聚焦光纤的平面透镜,可以实现对入射光线振幅、相位、偏振等参量的灵活调控。

微透镜阵列在概念上与超透镜类似,是由一系列微米级别的微小透镜构成的阵列,可以实现传统单光学镜片无法实现的复杂功能。Intel基于异构微透镜阵列技术研发出了180°FOV的小型紧凑VR头显设备。

超透镜(Metalens)与微透镜阵列这两个技术路径的优势就是集成度更高,可以用更小更轻薄的光学系统,满足XR设备的显示需求。尽管这两种方案尚处于研发初期阶段,但已经展示出非常强大的应用潜力。

我们在上文提到,移动端设备算力有限,XR设备难免受限。如果能将渲染挪到“云端”,也就是“实时云渲染”,可能会突破算力约束、实现高质量实时渲染。当前,实时云渲染最直观的应用就是云游戏。

首先,实时云渲染仅局限于单GPU,暂不兼容分布式运算,这一点和AI大模型天然支持分布式计算不同。

目前,业界正在探索在XR领域实现多卡分布式渲染,提高算力,但进展较为缓慢。如果未来分布式渲染能够实现突破,可能我们在使用VR设备时,就像我们今天能够在手机上使用AI相关的应用,体验到远超移动端本身的算力性能。

实时云渲染的另一个难点在于,它增加了基于网络的视频推流环节,更难控制画面延迟的问题。针对视频的网络延迟控制,视频编解码优化与端云异步渲染是当前主要的发展方向。

视频编解码优化是指,在视频推流时用一套云端专用的编解码定制芯片替代CPU和GPU,来优化延迟。它可以把整个编解码的时间降到1毫秒以内,并尽可能压缩各个环节的时间。

端云异步渲染是指将画面渲染与终端显示并行执行。云端渲染好基础画面,终端根据用户位置和姿态二次计算得到实时画面,从而减少延迟。

所以,渲染的技术进步中,不仅有移动端硬件的机会,比如在更高节点进行网络通讯和数据通讯;在软件层面,也有更适合云端渲染的新渲染技术的机会。

从2023年上半年开始,主算力芯片加协处理芯片的双芯片方案已经成为XR业内的主流处理器方案。通过一个XR协处理专用芯片为主芯片排忧解难,两个芯片共同配合工作,能够有效提升使用效果和计算效率。

作为负责空间计算和感知的专用芯片,用于XR的协处理芯片相当于以前手机上的M系列芯片,它可以实现前端摄像头加传感器数据的感知合成、SLAM建图、Mapping及手势跟踪等复杂功能。主处理芯片则只需进行核心逻辑运算。

苹果Vision Pro中,R1芯片作为协处理器,负责处理来自12个视觉摄像头,5个传感器,6个麦克风输入信号的数据处理工作,实现空间计算所需的姿态跟踪、眼动跟踪、3D环境感知以及手势跟踪等核心功能,动态延迟仅有12毫秒。

目前协处理器所执行的任务仍相对简单。未来,分区渲染、双眼焦点的渲染等更复杂的功能或将逐步转移到协处理器上运行,我们认为,随着苹果的示范效应,未来协处理器的定义和功能仍有机会拓展,并解决更多面向XR的专有需求。面向XR行业的双芯片架构将会在未来成为主流趋势。

站在科技创业投资的角度,峰瑞一直关注关键技术点的突破,及其带来的爆发性商业机会。苹果的Vision Pro既为XR行业打了个样,也将助力XR领域吸引更多的关注与创业资源。

而XR设备想要实现更好的产品体验,离不开 关键技术迭代 。当技术不断成熟后,XR设备能应用到更多场景,为更多用户带来实打实的核心价值。

我们认为,技术研发的关键挑战在于 提升XR的视觉与交互体验 。这背后不仅涉及到硬件端的显示模组、光学系统、交互模组,也依赖软件层面CG实时渲染技术的进一步发展。此外,如何改善画面运动延迟、提升沉浸感也是目前XR设备的一大痛点。

我们也会持续关注在 MicroLED、新型光学系统,以及CG实时渲染等相关软硬件技术的突破。 这些技术革新将助力XR设备未来成为下一代移动计算设备,甚至有可能创造出类似于智能手机替代传统PC的大变革机会。

畅想未来,可能在几年内,用户戴上XR设备之后,就能像钢铁侠那样去体验各种各样XR带来的一些有意思的新应用。这些新应用不仅是提升生产力的应用,还包括娱乐应用。也许那时候,我们无需攒人品去抢一张周杰伦的演唱会,通过XR设备,就能沉浸式地从家里的沙发,瞬移到鸟巢体育场的座位。